Sommaire

- Chatbot LLM : Qu'est-ce qu'un LLM ?

- Comment créer son chatbot LLM (développement étape par étape)

- Les erreurs classiques à éviter quand on conçoit un assistant LLM

- Comment l'assistant IA de Ringover utilise-t-il les LLM ?

- Pourquoi l'amélioration continue est-elle indispensable pour les chatbots LLM

- Peut-on réellement optimiser le parcours de ses clients avec un chatbot LLM ?

- En résumé : le chatbot LLM, bien plus qu'un simple outil

- FAQ sur les chatbots LLM

L'intelligence artificielle conversationnelle franchit aujourd'hui un cap décisif. Grâce aux modèles de langage de grande taille (les fameux LLM), les chatbots ne se contentent plus de réciter des scripts figés : ils deviennent de véritables assistants IA qui s'invitent dans les échanges avec une aisance nouvelle.

Ils sont capables de s'adapter, de reformuler, de comprendre les nuances, parfois même de devancer les intentions.

Cette évolution modifie en profondeur la manière dont les entreprises dialoguent avec leurs clients, que ce soit pour les assister, les orienter dans leur parcours d'achat, ou simplement leur faire gagner du temps.

Là où, hier encore, une réponse automatique manquait souvent de pertinence ou de subtilité, les nouveaux assistants dopés à l'IA parviennent désormais à tenir une conversation.

Explorons comment les LLM révolutionnent les chatbots. Identifions les écueils courants dans la création d'un assistant IA ainsi que les bonnes pratiques pour en tirer parti.

Chatbot LLM : Qu'est-ce qu'un LLM ?

Définition : Qu'entend-on par LLM exactement ?

Derrière l'acronyme LLM pour Large Language Model, ou modèle de langage de grande taille se cache une technologie dont l'ambition va bien au-delà de la simple compréhension de texte. Ces modèles représentent une avancée majeure dans le champ du traitement automatique du langage naturel. Cette avancée est portée par une croissance exponentielle de leur complexité : là où les générations précédentes manipulaient quelques millions de paramètres, les LLM actuels en mobilisent des milliards.

Quelles sont les possibilités offertes par les LLM ?

Mais au-delà des chiffres, ce sont les capacités qui impressionnent. Ces modèles apprennent à repérer des régularités dans la langue, à identifier des intentions implicites, à générer des contenus structurés, parfois même à simuler le raisonnement de façon surprenante.

En pratique, cela se traduit par une grande polyvalence : génération de réponses contextuelles, résumés automatisés, traduction multilingue, reformulation de textes, et bien d'autres usages encore.

La différence avec les “anciens modèles”

Ce qui les distingue des anciens systèmes, ce n'est pas uniquement leur volume. C'est leur aptitude à fonctionner de manière transversale, sans qu'il soit nécessaire de les reprogrammer pour chaque tâche. On leur soumet une consigne, parfois floue, parfois précise ; ils s'en saisissent, interprètent, produisent. Un peu comme un collaborateur qui apprend vite — mais qu'il faut savoir encadrer.

Évidemment, tout cela repose sur une phase d'entraînement massive, nourrie par des corpus colossaux issus du web, de livres, d'échanges humains. Et si cette abondance fait leur force, elle appelle aussi à la prudence : un modèle entraîné à tout voir peut aussi reproduire “ce qu'il ne faudrait pas dire”.

Comment fonctionne un LLM, concrètement ?

Soulevons le capot d'un LLM pour observer son architecture bien particulière : celle des transformers, un type de réseau de neurones qui a redéfini les standards du traitement du langage.

Ce n'est pas une coïncidence si ces modèles ont pris leur essor au moment où les volumes de données et la puissance de calcul ont permis de franchir certains seuils qui étaient, jusqu'alors, inaccessibles.

Un LLM s'entraîne sur des volumes de textes d'une ampleur difficile à se représenter : plusieurs pétaoctets parfois, collectés à travers livres, sites web, forums, articles, etc.

Comment l'apprentissage LLM débute-t-il ?

Dans un premier temps, l'apprentissage se fera sans consignes précises. C'est ce qu'on appelle une phase non supervisée : le modèle lit, décortique, assimile.

Il “apprend” par observation, en repérant les régularités du langage, les cooccurrences, les subtilités de sens qui pourraient même échapper dans certains cas à un lecteur humain.

Comprendre les mécanismes de fine-tuning et de self-attention

Ensuite, vient une phase plus ciblée : le fine-tuning. On affine le modèle à l'aide de données annotées. Cela permet de renforcer sa précision sur certaines tâches et contribue à le rendre plus conforme à un usage professionnel. C'est à cette étape que l'on commence à cadrer ses réponses, à lui transmettre des intentions, et… des garde-fous.

Le cœur de ce fonctionnement repose sur le mécanisme d'attention, ou plus précisément de self-attention. Il s'agit, en résumé, de la capacité du modèle à peser l'importance relative de chaque mot dans une phrase, en fonction de son contexte.

Contrairement à des approches plus linéaires, ici, tout interagit avec tout. En effe, chaque mot peut influencer l'interprétation des autres, même placé à distance dans la séquence. C'est ce qui permet à un modèle de saisir les subtilités, les ambigüités, ainsi que les changements de ton ou de registre.

La capacité de “prédiction” des LLM expliquée

Une fois formé, le modèle fonctionne selon un principe de prédiction : il génère du texte mot après mot, en tenant compte de ce qui précède. Ce n'est pas une simple imitation, mais une synthèse probabiliste alimentée par ce qu'il a vu, appris et intégré lors des précédentes phases évoquées.

C'est cette capacité à prolonger une pensée de manière fluide, et contextuellement pertinente, qui explique son succès dans des applications comme les chatbots, les assistants conversationnels, ou la création de contenu.

Bien sûr, cette mécanique n'est pas infaillible. Mais elle ouvre un champ de possibilités qui, il y a encore quelques années, relevait davantage de la science-fiction que de l'outil métier.

Comment créer son chatbot LLM (développement étape par étape)

La création d'un chatbot LLM est un projet structuré, parfois délicat, qui mêle stratégie, données, développement, interface et évolution continue.

Voici un aperçu des grandes étapes pour bâtir un assistant virtuel IA réellement utile pour vos utilisateurs.

1. Poser les fondations pour cadrer le projet

Tout commence par une phase de clarification. Avant d'écrire la moindre ligne de code, il est nécessaire de répondre à quelques questions de fond. Pourquoi créer ce chatbot ? Quelles interactions doit-il couvrir ? Est-il censé guider, informer, vendre, rassurer… ou un peu de tout cela à la fois ?

Ce travail de cadrage passe aussi par l'identification des utilisateurs visés. Comprendre leurs attentes, leurs habitudes, leurs problématiques, aide à définir les scénarios prioritaires. À ce stade, on définit aussi les indicateurs de réussite, sans perdre de vue que ces derniers évolueront avec l'usage.

Enfin, ne négligeons pas l'infrastructure : quel socle technique ? Quelles ressources internes pour le maintenir ? Quelles données disponibles, ou à collecter ? Quelle solution de création de chatbot ? Anticiper ces points, c'est éviter bien des écueils en aval.

2. Rassembler et préparer les données : l'étape cruciale

Un LLM, aussi puissant soit-il, reste tributaire des données qu'on lui fournit. C'est là que tout se joue. L'objectif ici est de construire un corpus suffisamment riche et représentatif pour refléter les futures interactions entre votre chatbot et ses utilisateurs.

Cela implique de collecter des dialogues, des tickets de support, des extraits de FAQ, des verbatims issus du CRM : tout ce qui peut nourrir le modèle avec des cas concrets.

Cependant, il est important de nettoyer, filtrer et restructurer ces données. La qualité prime sur la quantité, même si, dans l'idéal, on cherche à combiner les deux.

La diversité est un autre critère clé. Varier les formulations, les tons, les intentions, permet au bot ia de mieux s'adapter à des situations réelles. Et, surtout, d'éviter de reproduire des biais nuisibles à l'expérience.

3. Entraîner le modèle : précision et parcimonie

Une fois les données en main, vient le moment d'affiner le modèle. Ce n'est pas toujours nécessaire de l'entraîner de zéro — l'usage de modèles préexistants, que l'on fine-tune, est souvent plus judicieux, notamment en B2B.

Durant cette phase, plusieurs paramètres entrent en jeu : le nombre d'itérations, le taux d'apprentissage, les règles de validation… L'enjeu n'est pas de rendre le modèle omniscient, mais pertinent. Mieux vaut un chatbot qui excelle sur un périmètre restreint qu'un généraliste approximatif.

4. Concevoir l'interface : là où tout prend vie

Un bon moteur ne suffit pas, encore faut-il une carrosserie adaptée. L'interface est le point de contact, le lieu d'interaction avec le client/visiteur/prospect/utilisateur. Elle se doit d'être claire, fluide, sans fioritures inutiles. Un utilisateur ne s'attarde pas sur un chatbot dont il ne comprend pas le fonctionnement dès les premières secondes.

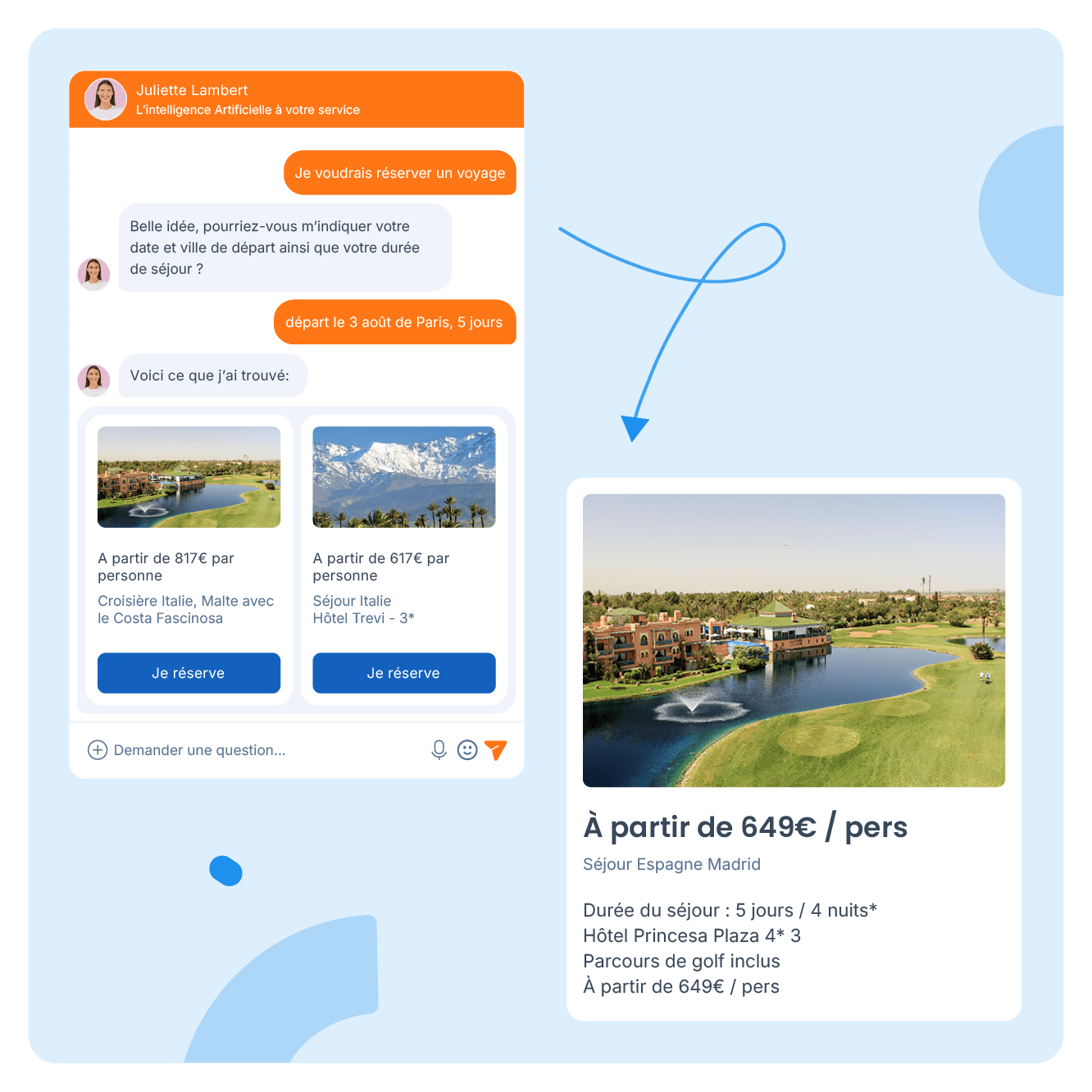

Target First, par exemple, offre un environnement accessible pour personnaliser l'interface de son assistant. Mais l'enjeu ne se limite pas au visuel : il s'agit aussi de bien gérer les entrées utilisateur, d'adapter les réponses à l'état de la conversation, et d'inspirer confiance dès les premiers échanges.

Pour les cas d'usage complexes, on peut intégrer une logique de RAG (Retrieval-Augmented Generation). Cette technique hybride permet au chatbot d'aller puiser dans une base documentaire avant de générer sa réponse, apportant ainsi une profondeur et une justesse accrues. Cela se révélera particulièrement utile dans les domaines réglementés ou techniques.

5. Déployer, tester, améliorer : un cycle sans fin

Le moment du déploiement est important, mais il ne signe en rien la fin du projet. C'est, en réalité, là que tout commence vraiment.

Le chatbot doit être suivi, évalué, corrigé. Ses performances peuvent évoluer au fil du temps, parfois à la hausse, parfois à la baisse, notamment si les attentes utilisateurs changent ou si les données deviennent obsolètes. Parmi les leviers d'amélioration continue, on compte :

- La mise à jour régulière du corpus,

- Les tests d'interactions réels,

- Les ajustements de tonalité ou de structure

Sans ce suivi, un chatbot peut rapidement devenir désuet, voire contre-productif. En résumé, votre outil IA, lui aussi, doit être supervisé.

Les erreurs classiques à éviter quand on conçoit un assistant LLM

Même bien outillé, un projet de chatbot peut dérailler si certains pièges ne sont pas anticipés. Voici une liste d'erreurs fréquentes qu'on rencontre dans les projets de chatbots LLM et des conseils pratiques pour les éviter.

1. Lancer le projet sans cap clair

C'est l'erreur de base : vouloir créer un chatbot… sans définir exactement à quoi il doit servir. Il y a de fortes chances d'aboutir à un assistant brouillon, qui répond à côté ou qui part dans tous les sens. Du côté de l'utilisateur, cela risque évidemment, de coincer.

Pour éviter cet écueil, répondez à une question simple dès le départ : “Quel problème le chatbot est-il censé résoudre ? “

S'il doit gérer des questions sur les livraisons, par exemple, alors tout son comportement doit tourner autour de ce périmètre — pas plus, pas moins. Plus le cadre est clair, plus l'agent IA est cohérent.

2. Oublier de personnaliser l'expérience

Un chatbot qui s'adresse à tout le monde de la même manière, c'est un peu comme un conseiller client qui ne regarde jamais le dossier de l'appelant. Ce manque de personnalisation peut finir par agacer.

Il est important de fournir l'assistant aux bonnes sources : CRM, historique d'achat, préférences utilisateur… Dès que l'expérience semble "sur-mesure", l'interaction devient plus fluide. À l'inverse, si l'utilisateur doit répéter ce qu'il a déjà communiqué, ou aller chercher lui-même ses infos, le chatbot perd son intérêt.

3. Se limiter à des arbres décisionnels

Beaucoup de chatbots anciens reposaient sur des workflows rigides. On clique sur un bouton, puis un autre, puis un autre. Et si la question sort du cadre prévu ? Le chatbot cale, ou renvoie vers un formulaire.

L'intégration de l'IA change la donne. Le chatbot peut désormais comprendre des requêtes formulées de façon naturelle, traiter l'imprévu, et proposer des réponses intelligentes même en dehors des scénarios prévus. C'est là qu'on passe du statut d'assistant "automate" à celui d'assistant "intelligent".

4. Trop remplir la base de connaissances

Vouloir tout inclure dans la base documentaire du chatbot est une tentation classique. Cela peut s'avérer contre-productif. Trop de data tue la data : le modèle finit par s'embrouiller, mélanger les sujets, ou fournir des réponses floues.

Le bon réflexe à avoir est de travailler par itérations. Commencer avec un socle de connaissances ciblé, bien structuré, et l'enrichir petit à petit en fonction des usages réels.

5. Lancer sans vraie phase de test

Un chatbot non testé en conditions réelles, c'est un peu comme une voiture qui roule sans contrôle technique.

Les tests doivent couvrir tous les cas de figure : les requêtes classiques, bien sûr, mais aussi les formulations maladroites, les demandes ambiguës ou les cas limites. L'idée, c'est de repérer les bugs, d'ajuster les prompts et d'affiner les réponses. Effectuer des tests permet d'anticiper la majorité des frictions post-lancement.

6. Ne pas prévoir l'échec (et donc mal le gérer)

Tous les chatbots, même les meilleurs, se retrouveront tôt ou tard face à une question qu'ils ne comprennent pas. Ce n'est pas grave en soi, à condition d'avoir prévu le coup. L'anticipation est la clé.

Quand un chatbot ne sait pas, il doit le formuler clairement. Et surtout proposer un plan B, une alternative comme :

- Reformuler la question

- Orienter vers une ressource utile

- Escalader vers un humain

Le silence, les réponses absurdes ou les boucles infinies, en revanche, détruisent la confiance très rapidement

7. Négliger la sécurité et la confidentialité

Un assistant LLM mal encadré peut devenir une porte d'entrée pour des usages indésirables : fuites d'informations, injection de prompts, réponses non maîtrisées… Les risques ne sont pas juste théoriques.

Adopter une logique Zero Trust est une bonne base pour limiter les risques et se mettre en conformité avec des réglementations telles que celles de l'IA Act, le RGPD, etc.

Concrètement, cette logique consiste de filtrer les entrées, valider les sorties, limiter les permissions, cloisonner les accès.

Le tout sans jamais exposer des données sensibles ou stratégiques sans vérification. La sécurité ne doit pas être une surcouche ajoutée à la fin — elle fait partie intégrante de l'architecture.

Comment l'assistant IA de Ringover utilise-t-il les LLM ?

L'assistant IA de Ringover exploite les Large Language Models (LLM) pour optimiser l'expérience client, renforcer ses capacités et augmenter la productivité des entreprises.

Une intelligence façonnée par vos données

Ce qui distingue réellement l'assistant IA de Ringover, c'est sa capacité à s'ancrer dans votre réalité métier. Contrairement aux systèmes génériques, il ne fonctionne pas en vase clos. Il s'alimente de vos données internes : CRM, catalogue produits, historique client, etc. Ainsi, il est en mesure d'ajuster ses réponses au plus près du contexte, et ce, sans s'égarer dans des généralités.

Une commande en attente, une réclamation spécifique, une demande récurrente, une demande de conseil par rapport à un produit ? L'assistant les comprend dans leur contexte, et adapte son discours en conséquence.

Il dépasse le cadre d'un simple chatbot scripté pour entrer dans une logique de service véritablement contextualisé : c'est un véritable assistant IA.

Génératif, mais pas mécanique

L'intégration de l'IA générative ouvre une autre dimension : celle d'une conversation vivante, qui simule remarquablement le langage naturel. Grâce aux techniques avancées de NLP (traitement automatique du langage), l'assistant de Ringover navigue avec souplesse entre les intentions, les formulations diverses, et même les imprécisions propres aux échanges humains.

Il ne se contente pas de “répondre”, il conseille, propose, reformule. Il transforme ainsi une simple requête en opportunité d'engagement ou de conversion. C'est aussi cette dynamique mise en œuvre par Target First qui a convaincu Ringover de l'acquérir en 2025.

Une présence continue

L'un des apports concrets de cette technologie se manifeste dans la gestion du support client. L'assistant Ringover assure une continuité de service sans interruption, capable de traiter à toute heure les demandes standards — suivis de commandes, questions sur les services, problèmes fréquents.

Ce fonctionnement allège considérablement la pression qui repose sur les équipes humaines, qui peuvent ainsi se concentrer sur les cas plus complexes, les appels sensibles, ou la relation de long terme.

Dans les faits, cela se traduit par des délais de réponse raccourcis, une meilleure satisfaction utilisateur, et une montée en gamme du service rendu.

Pourquoi l'amélioration continue est-elle indispensable pour les chatbots LLM

L'amélioration continue n'est pas une option : c'est une nécessité opérationnelle, stratégique et technologique.

Une réponse agile dans un environnement qui évolue constamment

Les comportements utilisateurs ne suivent aucun canevas immuable. Ils évoluent au gré des tendances, des usages, des contextes culturels ou encore économique.

En intégrant régulièrement de nouvelles données, un assistant IA peut ajuster ses réponses et affiner ses priorités. Il peut aussi continuer à apporter de la valeur là où elle est attendue, sans tomber dans le travers du hors-sujet.

Cette agilité ne s'improvise pas, elle s'organise. C'est par une boucle d'ajustements successifs que le modèle peut apprendre à interpréter les signaux faibles. Ce sont des indices souvent décisifs qui font toute la différence entre une interaction utile et une interaction oubliable.

Un levier pour affiner la pertinence des réponses

Même les meilleurs modèles peuvent être approximatifs. Ils peuvent mal interpréter un mot, s'égarer dans une réponse trop générique, ou proposer une solution déconnectée du contexte. Là encore, l'amélioration continue joue son rôle de filtre et de catalyseur puisqu'elle permet de corriger les écarts, d'atténuer les biais et d'accroître la justesse des réponses fournies.

Le fine-tuning sur des corpus actualisés, associé à des processus rigoureux de validation, garantit que le modèle ne se contente pas de répondre.

La RAG : une porte ouverte vers les innovations technologiques

L'univers de l'IA est traversé par des mutations rapides. De nouvelles architectures voient le jour, des méthodes comme la retrieval-augmented generation (RAG) repoussent les limites du traitement d'information, et l'intégration d'interfaces vocales devient monnaie courante.

Ignorer ces avancées, c'est risquer de laisser son chatbot intelligent glisser lentement, mais sûrement dans l'obsolescence. À l'inverse, en s'inscrivant dans une démarche d'amélioration continue, on maintient une forme d'élan technologique qui vous permet de rester compétitif, et d'anticiper les attentes de votre audience.

Une vigilance accrue sur la sécurité des échanges

Derrière chaque ligne de code, il y a des données. Et derrière chaque donnée, il y a aussi un part de chaque utilisateur. La protection de ces informations doit être inscrite au cœur du processus d'évolution du chatbot. L'amélioration continue offre un cadre structurant pour :

- identifier les vulnérabilités

- ajuster les permissions

- renforcer les protocoles de chiffrement

- s'assurer de la conformité avec les réglementations en vigueur

C'est un travail de fourmi souvent invisible à l'utilisateur, mais dont l'impact se mesure à long terme, à travers la confiance qu'un client accorde à une interface “automatisée”.

Rester aligné sur la stratégie de l'entreprise

Un chatbot ne doit pas être pensé comme un élément isolé. Il doit s'inscrire dans une logique d'entreprise, dans une vision plus large.

À mesure que les priorités internes évoluent, qu'il s'agisse du lancement d'un nouveau produit, de l'évolution du discours commercial, d'un changement de ton dans la communication, l'agent conversationnel doit être ajusté pour refléter ces transformations.

C'est précisément ce que permet l'amélioration continue : une mise à jour régulière, pas seulement technique, mais aussi stratégique, garantissant que le chatbot LLM reste un levier cohérent et utile pour l'ensemble des parties prenantes.

Peut-on réellement optimiser le parcours de ses clients avec un chatbot LLM ?

Cette question mérite plus qu'une réponse banale et rapide. Derrière l'engouement pour ces modèles se cache un potentiel bien plus vaste qu'il n'y paraît au premier abord : un potentiel qui, bien exploité, transforme non seulement les points de contact, mais aussi la manière dont une entreprise orchestre toute sa relation client.

Une interaction pensée à l'échelle de chaque utilisateur

Lorsqu'un chatbot LLM ajuste ses réponses à la lumière d'un historique, de données CRM croisées ou d'éléments contextuels, il ne se contente pas de reformuler un message. Il donne de la consistance à la relation.

C'est au cœur de cette approche que naît la pertinence, celle qui peut potentiellement faire mouche dès les premiers mots. C'est souvent à ce moment qu'une bonne expérience utilisateur se dessine

L'immédiateté est un standard

Il fut un temps où patienter faisait partie du jeu. Aujourd'hui, ce paradigme s'est inversé. Désormais, le client est moins patient : il passe plus rapidement à autre chose ou peut s'agacer.

Offrir une réponse à la seconde, à toute heure, n'est donc pas une faveur, c'est un standard implicite, que les LLM respectent sans sourciller.

Les requêtes simples sont traitées dans l'instant, libérant les ressources humaines pour des interventions plus fines, plus sensibles. Et si la réactivité ne suffit pas à fidéliser vos clients, elle évite au moins de les décevoir.

Le chatbot LLM peut interpréter le non-dit

Dans toute interaction client, ce qui est exprimé n'est qu'une partie du message. Le ton, les hésitations, les termes choisis disent parfois plus que le contenu brut. Vous savez, cette question de la forme et du fond ?

Certains modèles LLM, lorsqu'ils sont correctement entraînés, parviennent à détecter ces signaux dits faibles comme une frustration latente, une insatisfaction masquée par de la politesse, une hésitation prononcée.

Adapter la réponse à ce faisceau d'indices, c'est poser un jalon vers un service plus humain, paradoxalement rendu possible par la machine.

Les chatbots facilitent l'accès à l'information

Il n'est pas rare que le client se sente perdu face à une documentation chargée ou des FAQ labyrinthiques ou qui tournent en rond. Les LLM viennent ici jouer un rôle d'intermédiaire. En reformulant, en synthétisant ou en extrayant l'information pertinente à partir de sources souvent dispersées, ils rendent la connaissance plus digeste.

C'est une forme d'intelligence utile, qui, en soit, n'est pas spectaculaire, mais profondément précieuse.

Une assistance omnicanale

Dans un écosystème où les canaux se multiplient (chat web, WhatsApp, téléphone, réseaux sociaux…), la cohérence est un enjeu central. Un utilisateur qui commence une demande via le site web et la poursuit sur une messagerie mobile attend une continuité.

Les LLM, lorsqu'ils sont intégrés de façon fluide dans l'ensemble de ces points de contact, permettent cette homogénéité.

C'est un gage de sérieux, celui qu'on associe aux marques fiables, prévisibles, professionnelles.

En résumé : le chatbot LLM, bien plus qu'un simple outil

Longtemps cantonnés à des échanges prévisibles, les chatbots connaissent aujourd'hui une véritable mue. Portés par les avancées des modèles de langage (LLM), ils s'affranchissent des scripts linéaires pour offrir des interactions bien plus nuancées, presque naturelles. Ces assistants IA saisissent le contexte, reformulent et s'adaptent

Cependant, cette intelligence apparente ne fait pas tout. Derrière un chatbot réellement utile se cache une architecture réfléchie, où rien n'est laissé au hasard :

- Pertinence des cas d'usage

- Qualité d'entraînement

- Conception de l'interface

- Analyse continue des performances

Ce sont là autant de paramètres qu'il faut ajuster avec soin : un outil mal calibré peut vite devenir contre-productif, voire frustrant pour l'utilisateur.

Développer un assistant IA n'est donc ni un projet accessoire, ni une simple tendance. C'est une démarche stratégique, exigeante mais porteuse : bien intégré, il fluidifie le parcours client et absorbe les demandes récurrentes.

💡 Et si c'était le bon moment pour repenser votre manière d'interagir avec vos clients ou prospects ? L'assistant IA de Ringover vous permet de bâtir un agent conversationnel à votre image, capable d'échanger intelligemment avec vos visiteurs, de les guider, de les qualifier même lorsque vos bureaux sont fermés.

Une solution pensée pour conjuguer efficacité commerciale et qualité d'expérience, sans compromis. Contactez nos experts IA et demandez une démo !

FAQ sur les chatbots LLM

Qu'est-ce qu'un chatbot LLM ?

Un chatbot LLM désigne un agent conversationnel alimenté par un grand modèle de langage. Contrairement aux systèmes à base de règles, il s'appuie sur une compréhension statistique du langage pour interagir de manière fluide, avec un degré d'adaptabilité bien supérieur. Ces outils peuvent analyser une question, la reformuler mentalement, puis y répondre de façon cohérente, même en dehors des scénarios prévus à l'avance.

Chatbot et grands modèles de langage : quels sont les enjeux pour les entreprises ?

Les chatbots basés sur les LLM soulèvent des questions importantes, à la fois techniques et stratégiques :

- La compréhension fine du langage naturel : Ce n'est pas seulement une question de syntaxe ou de vocabulaire, mais de capacité à capter les intentions réelles des utilisateurs pour y répondre avec pertinence.

- l'adaptabilité en continu : Certains modèles sont conçus pour intégrer de nouvelles données et ajuster leurs réponses avec le temps. Cela ouvre la voie à des agents capables d'évoluer au fil des usages, au lieu de rester figés dans une version statique.

- Pouvoir passer la main à un conseiller humain : Cela reste un garde-fou indispensable. Même les meilleurs algorithmes ont leurs limites, et savoir détecter quand l'intervention humaine devient nécessaire, c'est aussi garantir une interaction sans impasse.

Qu'est-ce qu'un grand modèle de langage ?

Un grand modèle de langage (LLM, pour Large Language Model) est un système d'intelligence artificielle entraîné à comprendre, prédire et générer du texte en langage naturel. Il s'appuie généralement sur une architecture dite transformer — un type de réseau de neurones qui excelle dans le traitement de séquences complexes.

Grâce à un entraînement sur des volumes massifs de textes issus de sources diverses, ces modèles développent une forme de “connaissance implicite” du langage. Cela ne signifie pas qu'ils comprennent le monde comme les humains, mais qu'ils savent repérer des régularités, des nuances, et même, parfois, des sous-entendus.

Quelle est la différence entre un chatbot traditionnel et un chatbot LLM ?

Le chatbot traditionnel ou simple repose sur des scénarios balisés, avec des règles conditionnelles et des réponses programmées à l'avance. C'est efficace pour des demandes simples et répétitives, mais cela montre rapidement ses limites dès qu'une requête sort du cadre prévu.

Un chatbot LLM, en revanche, n'a pas besoin d'être “prévenu” à l'avance de toutes les questions possibles. Il analyse la requête en temps réel, en déduit le sens, et formule une réponse adaptée, même si la formulation de départ est floue, ambigüe ou inédite. Il ne remplace pas les scénarios métier, mais les complète avec une flexibilité plutôt appréciable.

Quels sont les grands LLM ?

L'essor de l'intelligence artificielle ces dernières années a donné naissance à une nouvelle génération de modèles de langage aux capacités impressionnantes. Certains sont devenus des références industrielles ; d'autres, plus récents, cherchent à redéfinir les standards en s'appuyant sur des approches ouvertes ou des architectures plus ciblées.

- GPT-4 – OpenAI : Depuis son lancement, GPT-4 suscite autant d'intérêt que de spéculations. OpenAI n'a pas communiqué de chiffre précis sur le nombre de paramètres. C'est un choix qui entretient un certain mystère, mais plusieurs sources évoquent des tailles bien supérieures à la génération précédente (175 milliards !). Ce qui distingue GPT-4, au-delà de sa puissance brute, c'est sa capacité à interpréter des requêtes complexes avec un sens aigu du contexte, y compris dans des domaines très spécialisés.

- LLaMA 3 – Meta : Dévoilé en 2024, LLaMA 3 (Large Language Model Meta AI) se décline en plusieurs tailles — de 8 à 70 milliards de paramètres — et fait le pari de l'open source, une orientation stratégique qui séduit un nombre croissant d'acteurs en quête de transparence ou d'autonomie technique. Sur certaines tâches, notamment le raisonnement logique ou le codage, il parvient à dépasser des modèles plus volumineux, preuve que l'optimisation fine compte parfois autant que la puissance de calcul.

- Mistral – Mistral AI Dans un paysage largement dominé par les géants américains, Mistral AI, entreprise française, apporte une alternative crédible et performante. Son modèle, également open-source, a été pensé pour fonctionner de manière décentralisée, ce qui facilite son déploiement en local ou sur des infrastructures maîtrisées. Une orientation qui séduit autant pour des raisons techniques que réglementaires.

- Falcon 180B : Conçu aux Émirats arabes unis, Falcon 180B s'impose par sa taille — 180 milliards de paramètres — mais aussi par sa mise à disposition en open source, ce qui reste rare à ce niveau. Il est particulièrement apprécié dans les contextes où les entreprises cherchent à entraîner ou adapter elles-mêmes un modèle à grande échelle, sans dépendre d'une API propriétaire.

- Gemini : Successeur de Bard, Gemini incarne la nouvelle génération de modèles de langage développés par Google DeepMind. Conçue pour être à la fois multimodale (capable de traiter texte, images, audio et code) et intégrée nativement à l'écosystème Google, cette famille de modèles ambitionne de combiner puissance, flexibilité et convivialité. Si Bard marquait une première étape dans les interfaces conversationnelles made by Google, Gemini, lui, vise clairement l'usage professionnel à grande échelle.

![Chatbot LLM : guide, fonctionnement, développement et avantages [2025]](https://webcdn.ringover.com/img/big/chatbot%20LLM-d8c59.png)